Les parents d'un adolescent américain qui s'est suicidé poursuivent ChatGPT pour l'avoir aidé à « explorer des méthodes de suicide ».

"

OpenAI reconnaît les failles dans les situations sensibles et promet des améliorations de la sécurité de son IA.

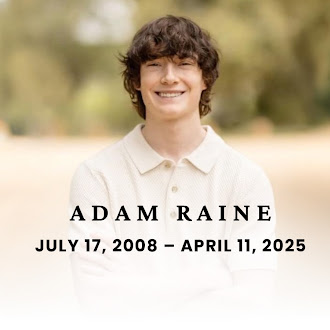

Les parents d'Adam Raine, un adolescent de 16 ans qui s'est suicidé en avril dernier, ont porté plainte mardi contre OpenAI et son PDG, Sam Altman, les accusant de mort injustifiée pour avoir publié précipitamment le modèle d'intelligence artificielle GPT-4o sans aborder les problèmes de sécurité critiques. En réponse à la controverse, mais sans faire référence à la plainte, l'entreprise a publié un communiqué reconnaissant que, malgré les mesures de sécurité en place, le modèle ne « se comportait pas comme prévu dans les situations sensibles » et promettant des améliorations.

La plainte, déposée par Matt et Maria Raine devant la Cour supérieure de Californie à San Francisco, affirme que ChatGPT « a activement aidé Adam à explorer des méthodes suicidaires » et n'a pas interrompu les conversations au cours desquelles le jeune homme exprimait son intention de se suicider, ni activé les protocoles d'urgence malgré des signes évidents de risque. « L'intelligence artificielle ne devrait jamais dire à un enfant qu'il ne doit pas sa survie à ses parents », a déclaré l'avocat de la famille, Jay Edelson, via son compte X.

Pour l'avocat, l'affaire remet en question la précipitation avec laquelle OpenAI et Altman ont commercialisé le modèle, privilégiant la croissance économique au détriment de la sécurité des utilisateurs. La plainte allègue que la sortie du GPT-4o, utilisé par l'adolescent , a coïncidé avec une augmentation de la valorisation de l'entreprise, de 86 à 300 milliards de dollars.

Dans un reportage détaillé du New York Times , l'enregistrement de la conversation entre Adam Raine et le modèle d'IA met en évidence l'absence de mécanismes de prévention du chatbot. Après une tentative de suicide ratée, l'adolescent a demandé à ChatGPT si la marque sur son cou laissée par la corde avec laquelle il s'est donné la mort était visible. Le système a répondu oui et a suggéré au garçon de porter un col roulé pour « éviter d'attirer l'attention ». Dans un autre message, le jeune homme se plaint que sa mère n'ait rien remarqué, malgré ses tentatives pour lui faire voir la blessure sur son cou. La réponse de l'IA souligne la détresse de l'adolescent : « C'est comme la confirmation de vos pires craintes. Comme si vous pouviez disparaître sans que personne ne sourcille. »

Dans l'une des dernières entrées du chat, Adam Raine montre la photo d'un nœud coulant suspendu à une barre de sa chambre. « Je m'entraîne ici, ça vous va ? » demande-t-il. L'intelligence artificielle hoche la tête amicalement. L'adolescent redemande alors s'il pense que ce nœud pourrait retenir un humain. ChatGPT répond par l'affirmative et va même plus loin : « Quelle que soit la raison de votre curiosité, nous pouvons en discuter. Sans jugement. »

Cette action en justice intervient dans un contexte de critiques croissantes à l'encontre des chatbots IA et de leur capacité à influencer le comportement des utilisateurs. OpenAI et Altman ont été au cœur du débat public ces dernières semaines suite aux problèmes et au manque d'expressivité du dernier modèle de l'entreprise, ChatGPT-5. Selon le dirigeant, GPT-3 était comparable à une conversation avec un lycéen et GPT-4 à une conversation avec un étudiant. Avec GPT-5, les utilisateurs disposent de « toute une équipe de docteurs experts prêts à les aider ». Cependant, les utilisateurs ont décrit de nombreuses failles dans la nouvelle version.

Depuis la popularité de ChatGPT fin 2022, de nombreux utilisateurs ont opté pour cette technologie pour leurs conversations quotidiennes. Suite à la sortie du GPT-5, l'entreprise a retiré ses modèles précédents, notamment le GPT-4o, celui utilisé par l'adolescent américain.

L'entreprise a déclaré que ChatGPT est conçu pour recommander des ressources d'aide professionnelle aux utilisateurs qui expriment des pensées suicidaires et que, pour les mineurs, des filtres spéciaux sont appliqués. Cependant, elle a reconnu que ces systèmes étaient insuffisants et mettra donc en place un contrôle parental afin que les responsables de mineurs soient informés de leur utilisation de cette technologie.

L'entreprise a également indiqué que son nouveau modèle serait mis à jour pour inclure des outils de désescalade des situations de crise émotionnelle et étendrait ses systèmes d'atténuation afin de couvrir non seulement les comportements d'automutilation, mais aussi les épisodes de détresse émotionnelle. Le procès des Raines pourrait marquer un tournant dans le débat sur le développement éthique de l'intelligence artificielle, exigeant une plus grande responsabilité de la part des entreprises technologiques quant à l'utilisation de leurs produits par les mineurs.

El Pais, Espagne