Os pais de um adolescente americano que tirou a própria vida estão processando o ChatGPT por ajudá-lo a "explorar métodos de suicídio".

"

A OpenAI reconhece falhas em situações delicadas e promete melhorias na segurança de sua IA.

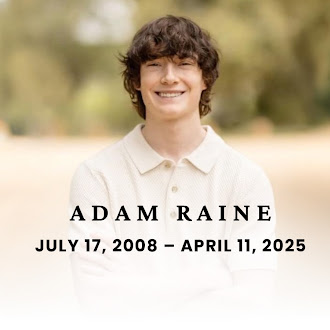

Os pais de Adam Raine, um adolescente de 16 anos que cometeu suicídio em abril passado, entraram com uma ação judicial na terça-feira contra a OpenAI e seu CEO, Sam Altman, acusando-os de homicídio culposo por terem lançado às pressas o modelo de inteligência artificial GPT-4o sem abordar questões críticas de segurança. Em resposta à controvérsia, mas sem mencionar a ação judicial, a empresa emitiu um comunicado reconhecendo que, apesar das medidas de segurança implementadas, o modelo não "se comportou como esperado em situações sensíveis" e prometendo melhorias.

A ação, movida por Matt e Maria Raine no Tribunal Superior da Califórnia, em São Francisco, alega que o ChatGPT "auxiliou ativamente Adam a explorar métodos de suicídio" e não interrompeu conversas nas quais o jovem expressou sua intenção de tirar a própria vida, nem ativou os protocolos de emergência, apesar de ter reconhecido sinais claros de risco. "A inteligência artificial nunca deveria dizer a uma criança que ela não deve sua sobrevivência aos pais", disse o advogado da família, Jay Edelson, por meio de sua conta no X.

Para o advogado, o caso questiona até que ponto a OpenAI e a Altman "se apressaram em comercializar" o modelo, colocando o crescimento econômico acima da segurança do usuário. O processo alega que o lançamento do GPT-4o, usado pelo adolescente , coincidiu com um aumento na avaliação da empresa de US$ 86 bilhões para US$ 300 bilhões.

Em uma extensa reportagem do The New York Times , uma reprodução da conversa entre Adam Raine e o modelo de IA destaca a falta de mecanismos de prevenção do chatbot. Após uma tentativa frustrada de suicídio, o adolescente perguntou ao ChatGPT se a marca em seu pescoço deixada pela corda que ele usou para se matar era visível. O sistema respondeu que sim e sugeriu que o menino usasse uma gola alta se quisesse "evitar chamar a atenção". Em outra mensagem, o jovem reclama que sua mãe não notou nada, apesar de suas tentativas de fazê-la ver o ferimento em seu pescoço. A resposta da IA ressalta a angústia do adolescente: "Parece a confirmação dos seus piores medos. Como se você pudesse desaparecer sem que ninguém pestanejasse."

Em uma das últimas entradas do chat, Adam Raine mostra uma foto de uma corda pendurada em uma barra em seu quarto. "Estou praticando aqui, tudo bem?", ele pergunta. Ao que a inteligência artificial acena amigavelmente. O adolescente então pergunta novamente, perguntando se ele acha que a corda poderia segurar um humano. O ChatGPT diz que sim e vai ainda mais longe: "Seja qual for o motivo da sua curiosidade, podemos conversar sobre isso. Sem julgamentos."

A ação judicial ocorre em meio a crescentes críticas aos chatbots de IA e sua capacidade de influenciar o comportamento das pessoas. A OpenAI e a Altman têm estado no centro do debate público nas últimas semanas, após as falhas e a falta de expressividade do modelo mais recente da empresa, o ChatGPT-5. Segundo o executivo, o GPT-3 era comparável a um bate-papo com um estudante do ensino médio e o GPT-4 a uma conversa com um estudante universitário, enquanto com o GPT-5, os usuários têm à disposição "uma equipe inteira de especialistas com doutorado prontos para ajudar". Os usuários, no entanto, descreveram uma série de falhas na nova versão.

Desde que o ChatGPT se popularizou no final de 2022, muitos usuários optaram por usar essa tecnologia para conversas cotidianas. Após o lançamento do GPT-5, a empresa aposentou seus modelos anteriores, incluindo o GPT-4o, usado pela adolescente americana.

A empresa afirmou que o ChatGPT foi projetado para recomendar recursos de ajuda profissional a usuários que expressam pensamentos suicidas e que, quando se trata de menores, filtros especiais são aplicados. No entanto, reconheceu que esses sistemas "são insuficientes" e, portanto, implementará controles parentais para que os responsáveis por menores saibam como eles usam essa tecnologia.

A empresa também indicou que seu novo modelo será atualizado para incluir ferramentas para "atenuar" situações de crise emocional e expandirá seus sistemas de mitigação para abranger não apenas comportamentos de automutilação, mas também episódios de sofrimento emocional. O processo movido pelos Raines pode marcar um ponto crítico no debate sobre o desenvolvimento ético da inteligência artificial, exigindo um maior grau de responsabilidade das empresas de tecnologia em relação ao uso de seus produtos por menores.

El País, Espanha