Un plan pour documenter et discréditer les campagnes de désinformation

Le recueil de cas sur la manipulation des médias

Nieman Reports Article rédigé par:

BRIAN FRIEDBERG - EMILY DREYFUSS - GABRIELLE LIM - JOAN DONOVAN

Un outil pour aider les journalistes, chercheurs et législateurs à savoir comment et quand réagir à la désinformation sous toutes ses formes.

En 2020, au milieu d'une pandémie, de manifestations et d'élections présidentielles, la désinformation se cache partout. C'est sur nos réseaux sociaux, ça sort de la bouche de nos politiciens, et c'est imprimé sur des prospectus postés à nos portes, mêlés indiscernables avec les faits. L'Organisation mondiale de la santé l'a qualifié d'infodémie. Une partie de cela est le résultat de campagnes de manipulation intentionnelle des médias, d'escroqueries, de canulars et de gadgets conçus par des personnes avec un agenda. Cette désinformation, comme un virus, est contagieuse et potentiellement mortelle, pour les individus et pour la démocratie elle-même.

Cela n'a pas commencé de cette façon. L'avènement de la communication en ligne, et la grande possibilité de connexion qui l'accompagne, ont permis aux gens de se retrouver basés sur l'intérêt et l'affinité comme jamais auparavant, et sur de nouveaux outils pour ceux qui sont engagés dans la production culturelle. Des scientifiques innovants, des groupes de défense et des médias indépendants ont prospéré grâce aux nouvelles avancées en matière de communication réseau et de technologie à large bande, établissant leurs communautés sur le Web ouvert et les médias sociaux.

Mais alors que la naïveté de l'ère techno-utopique s'estompe dans les horreurs de l'infodémie, nous voyons maintenant des plateformes diriger la défense après avoir sciemment permis à la radicalisation de s'épanouir. Les dommages directs causés par les attaques de ransomwares à nos institutions vitales, les cyber-soldats des régimes oppressifs, les équipes de désinformation à but lucratif, les théories du complot nuisibles basées sur l'antisémitisme et la désinformation médicale, et la célébration de La violence extrémiste détruit nos institutions, qui ont peu ou pas de capacité à identifier l'origine de ces attaques.

Nous, dans l'équipe de la technologie et du changement social du Shorenstein Center de Harvard pour les médias, la politique et la politique, publions le recueil de cas sur la manipulation des médias pour aider à éliminer ce bruit. Le livre de cas est une base de données d'études de cas de campagnes de manipulation des médias, certaines anciennes, d'autres en cours, qui, nous l'espérons, fourniront un cadre d'analyse de ce phénomène. Nous souhaitons que cette plate-forme de recherche soit à la fois une ressource pour les universitaires et un outil pour aider les chercheurs, les technologues, les politiciens, les organisations de la société civile et les journalistes à savoir comment et quand répondre à la menace réelle de la manipulation des médias.

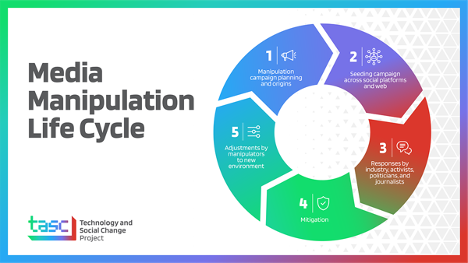

Le cœur du Casebook est le cycle de vie de la manipulation des médias, qui présente une méthodologie sur la façon de comprendre les origines et les impacts des campagnes de manipulation des médias, à la fois nationales et internationales, et leur relation avec l'écosystème de des informations plus détaillées. Situé dans le domaine émergent des études critiques sur Internet, il est le fruit de trois années de recherche sur la manière dont les journalistes, les groupes de la société civile et les technologues traitent la manipulation des médias et les campagnes de désinformation. Nous prenons au sérieux la nécessité d'un ensemble de définitions intersectorielles pour nous aider à donner un sens aux tactiques des manipulateurs et aux stratégies de communication qu'ils emploient pour induire le public en erreur.

Les différentes étapes du cycle de vie de la manipulation des médias Projet de changement social et technologique au Shorenstein Center for Media, Politics and Public Policy

Les différentes étapes du cycle de vie de la manipulation des médias Projet de changement social et technologique au Shorenstein Center for Media, Politics and Public Policy

Ici, nous décomposons le fonctionnement de chaque étape du cycle de vie et les façons dont différents groupes de personnes essayant de se défendre peuvent être les plus utiles. La manipulation des médias n'affecte pas seulement les journalistes et les entreprises de médias sociaux, elle représente un défi collectif pour nous tous qui croyons que la connaissance est le pouvoir. Tel un marteau dans un monde rempli de clous, le Casebook offre un moyen d'analyser les interactions dans notre écosystème médiatique qui est cohérent avec les pratiques d'enquête et journalistiques actuelles qui cherchent à nous rapprocher de la vérité.

Étape 1: planification de la campagne

Les campagnes de manipulation des médias sont le produit de notre culture et de la Silicon Valley. Au fur et à mesure que les produits de l'industrie technologique se répandaient dans le monde entier, poussés par une machine technocratique et à but lucratif, les problèmes sociaux préexistants se sont également reproduits et amplifiés. Dans de nombreuses campagnes de manipulation médiatique que nous avons répertoriées dans le Casebook, vous voyez de petits groupes d'acteurs motivés, souvent poussés par ces forces sociales toxiques, utilisant de manière opportuniste la technologie pour étendre et amplifier leur impact.

Il est extrêmement difficile de déterminer qui sont ces personnes et pourquoi elles agissent. Les plateformes de médias sociaux, principales cibles des extrémistes et des manipulateurs des médias, sont de plus en plus opaques et difficiles à étudier de manière critique. Cela fait de l'établissement de l'intention et de l'attribution d'artefacts de désinformation et de propagande nuisible un processus long et épuisant émotionnellement pour les journalistes et les chercheurs. Derrière chaque plan de campagne visible se cache une autre couche de communication invisible avec des étrangers, une autre nouvelle plateforme pour échapper à la réglementation et à la surveillance.

Mais l'opacité de la modération du contenu concernant ces matériaux fait de la recherche extérieure critique et du journalisme un élément si nécessaire pour pousser au changement.

La découverte de preuves de la planification et de la coordination des campagnes nécessite une expertise du domaine, ce qui prend du temps. Ces informations peuvent être collectées en temps réel par un observateur dédié à la tâche de comprendre la dynamique des espaces sous-culturels en ligne, mais ne sont souvent disponibles que sur le plan médico-légal. Nous savons dans quelle mesure l'extrême droite s'est organisée pour Unite the Right à cause des fuites de chat postées par Unicorn Riots, par exemple. Dans nos études de cas, lorsque cela est possible, nous illustrons à quoi ressemble le début d'une campagne et expliquons comment d'autres chercheurs et journalistes peuvent cultiver eux-mêmes cette expertise dans ce domaine. Nos études de cas sur le phénomène des faux comptes Antifa sur les réseaux sociaux et le blackface numérique «Operation Blaxit» montrent comment la planification et la coordination peuvent être détectées pour ceux qui savent où chercher.

Découvrir la planification de la campagne et définir l'intention est impossible sans une recherche qualitative qui contextualise comment et pourquoi elle a été créée. Plutôt que de s'appuyer sur de grands ensembles de données anonymisées fournis par ces plates-formes ou sur un accès de plus en plus restrictif à l'information, nos méthodes de recherche intègrent des connaissances ethnographiques, sociologiques et anthropologiques de la communication humaine pour donner un sens au désordre. Inclus dans notre package méthodologique est le «Ethnographie numérique d'investigation», un guide pour les universitaires et les journalistes cherchant à concevoir des enquêtes sur les médias sociaux qui mènent à une connaissance approfondie des communautés cibles de la désinformation et de celles qui la produisent de manière fiable. Bien qu'il y ait aussi une autre couche à une campagne de désinformation que nous ne pouvons pas voir, nous, en tant que journalistes et chercheurs, devons mener une enquête claire et reproductible pour traiter collectivement les nombreux préjudices en ligne auxquels nous sommes confrontés aujourd'hui.

Étape 2: Semer la campagne sur les plateformes sociales et le Web

L'étape 2 est lorsqu'une campagne passe de la planification à l'exécution, lorsque des mèmes, des hashtags, des contrefaçons et des informations fausses ou trompeuses sont diffusés sur les réseaux sociaux, les sites d'information marginaux, les blogs et les forums. Souvent, avec l'aide de participants volontaires, d'influenceurs en ligne et de factions du réseau, cette étape documente le premier stade auquel une campagne dépasse ses créateurs d'origine. Si les messages et les appels à l'action sont suffisamment intéressants, la campagne se développe et atteint de nouveaux publics qui n'ont souvent aucune idée des origines ou des motivations de ce qu'ils voient actuellement.

L'intervention à ce stade n'est pas claire. À quel moment intervenez-vous? À quel point le contenu est-il flagrant? Quel est le résultat probable? L'intervention sera-t-elle contre-productive? C'est là que les organisations de la société civile (OSC) jouent un rôle important. En raison de leur expertise dans le domaine et de leurs liens avec les individus et les groupes qui peuvent être les plus touchés par une opération d'influence peu motivée, les OSC ne sauront pas seulement où chercher, mais comprendront mieux les vecteurs d'attaque, les problèmes de coin qui se posent. ils feront face. exploité, et le contexte et les nuances pour discerner quelle action (le cas échéant) doit être entreprise. Ainsi, les OSC ayant la capacité de surveiller de telles activités deviennent un acteur inestimable pour empêcher une opération d'influence potentiellement dangereuse de passer à l'étape suivante.

Souvent avec plus de connaissances techniques et une action plus rapide, les OSC peuvent contrer les messages avant qu'ils n'atteignent des publics clés, rejeter les idées fausses potentielles sur un problème et agiter la réponse de la plateforme. Ici, l'humour et la créativité sont des atouts que les militants peuvent exploiter pour contrer l'erreur et la désinformation. Les OSC sont souvent les premières à remarquer quand quelque chose semble discutable et peut être une ressource fiable. Les entreprises technologiques et les chercheurs doivent également en prendre note, car les interventions les plus efficaces impliqueront probablement toutes les parties.

Étape 3: Réponses de l'industrie, des militants, des politiciens et des journalistes

L'étape 3 du modèle de cycle de vie décrit comment les personnes et les organisations hautement visibles réagissent et réagissent en dehors d'une campagne de manipulation. Ces personnes ou institutions peuvent être des politiciens, des agences gouvernementales, des célébrités, des influenceurs, des organisations de la société civile ou des journalistes. C'est presque toujours après les réactions de ces personnes culturellement puissantes qu'une campagne de manipulation devient plus visible et dangereuse. L'étape 3 est un tournant. Ce qui se passe pendant cette période critique détermine si la campagne reçoit une amplification et une attention indues, ou échoue.

C'est à ce stade que le jugement journalistique est le plus important. Les manipulateurs de médias ont besoin d'attention. Si l'objectif de l'étape 2 est d'attirer l'attention sur Internet, l'étape 3 est l'endroit où la campagne l'attrape.

Les journalistes sont souvent ceux qui trouvent ces pièges, car leur travail consiste à rechercher des informations importantes que le public a besoin de connaître. Les journalistes sont en chasse. Et c'est pourquoi ils doivent considérer les campagnes de manipulation des médias comme des pannes, réparties sur Internet pour se rattraper. Lorsqu'ils trouvent des preuves d'une campagne qui en est encore aux étapes 1 ou 2, les journalistes doivent soigneusement équilibrer la nécessité de rapporter des événements réels avec la nécessité de ne pas être victimes d'une campagne manipulatrice. Parfois, il n'est pas dans l'intérêt public de signaler les campagnes naissantes.

Pour déterminer si le reportage à l'étape 3 fera plus de bien que de mal, les journalistes doivent se demander: cette petite manipulation des médias a-t-elle le potentiel de causer un réel préjudice? Les influenceurs répondent-ils et font-ils passer le mot? Avez-vous l'impression que beaucoup de gens tombent amoureux et acceptent vos messages nuisibles? Si la réponse à ces questions est oui, alors le rapport est justifié. Si les réponses sont moins claires, ils doivent porter le meilleur jugement possible.

Comme le montrent certaines de nos études de cas, la pire chose que les journalistes puissent faire à l'étape 3 est de rapporter une campagne de manipulation médiatique à leur valeur nominale, en répétant la désinformation et le cadrage de la campagne. Dans ce cas, les journalistes ont été induits en erreur. C'est une victoire évidente pour les manipulateurs.

Mais les journalistes peuvent encore amplifier la campagne de manipulation même s'ils obtiennent les bons rapports, ce qui rend la troisième étape extrêmement difficile. Si la campagne de désinformation entrave les médias sociaux, un article de la presse grand public - même un article qui souligne avec précision à quel point la campagne est fausse ou fausse - pourrait être la combinaison qui allume le feu de l'opération.

Dans cette situation, la bonne décision peut être de ne pas écrire d'histoire, d'afficher un silence stratégique.

Mais s'il est trop tard pour le silence stratégique, par exemple parce que d'autres organes de presse l'amplifient déjà, ou que les plateformes de médias sociaux le servent à un large public qui agit déjà sur lui, ou parce que des personnes de premier plan le sont déjà ils y répondent. alors vous êtes déjà à l'étape 3 et il est approprié et même nécessaire d'en rendre compte.

Une façon de penser à cela est la suivante: en tant que journalistes, vous voulez rarement commencer l'étape 3. Vous ne voulez commencer l'étape 3 avec vos reportages que si une campagne a déjà gagné en popularité virale si cachée, hors de vue d'ensemble, qu'elle cause du tort ou ce sera imminent.

Dans ce cas, le plus important est de faire un rapport critique. Cela signifie mettre en œuvre une "amplification stratégique". Cela signifie suivre la rubrique du sandwich de vérité: commencer par ce qui est vrai, démystifier rapidement ce qui est faux, puis revenir à ce qui est connu. Ce que l'on sait peut être des choses comme qui est derrière la campagne, où elle a été planifiée, à qui ça fait mal, et comment elle s'inscrit dans le cycle actuel de l'actualité et le cycle de vie de la manipulation des médias. Ne créez pas de lien direct avec les identifiants et sites Web des opérateurs de campagne si vous pouvez l'éviter. Ne permettez pas aux lecteurs d'utiliser facilement vos rapports pour trouver, faire passer le mot et rejoindre la campagne.

Les journalistes ont également un rôle crucial à jouer dans l'étape 4: Atténuation. À l'étape 4, une campagne a atteint un point de basculement viral tel qu'une correction médiatique est clairement nécessaire. L'efficacité de ce correctif dépend de la situation, mais une telle information est toujours justifiée car la campagne a atteint un certain niveau de sensibilisation du public.

Étape 4: Atténuation

Une fois qu'une campagne est amplifiée dans la conscience publique, un certain nombre d'acteurs doivent agir pour atténuer ses dégâts. Le journalisme joue également un rôle crucial ici, en vérifiant activement les faits et en démystifiant les campagnes de désinformation individuelles, pour porter les actions et les impacts des acteurs malveillants sur les plateformes de médias sociaux à l'attention de la société civile, des technologues et des experts. législateurs.

Alors que les rédactions se sont adaptées au cours des quatre dernières années à la normalisation de la désinformation sur les réseaux sociaux, elles ont commencé à vérifier régulièrement les faits et à discréditer les rythmes. Les fact-checkers ont écrit des milliers d'articles pour démystifier la désinformation et les complots, car ils voient le public ciblé à plusieurs reprises pour un contenu sensationnel et scandaleux en ligne. C'est un gaspillage de ressources, qui pourrait être beaucoup mieux dépensé pour maintenir le journalisme plutôt que pour modérer le contenu sur les plateformes. Les contrôles de données dédiés sont une forme d'atténuation, dominant les résultats de référencement pour les campagnes de falsification confirmées.

Les efforts d'atténuation incombent souvent à la société civile, qui subit pendant des années la longue série de manipulations à mesure que la désinformation se répand. Les journalistes, les professionnels de la santé et de la santé publique, les dirigeants de la société civile et les forces de l'ordre supportent le véritable coût de la réponse à la désinformation continue.

Les preuves qu'ils collectent s'additionnent et peuvent aider les plateformes à modifier leurs systèmes ou leurs conditions d'utilisation. Les coalitions de la société civile, comme Change the Terms, font du lobbying depuis des années pour forcer les entreprises de plateformes à assumer la responsabilité des dommages qui prolifèrent sur leurs sites. La modération du contenu ne doit pas être la tâche de la société civile ou des communautés lésées.

Les entreprises de plate-forme sont celles qui exercent le pouvoir de la modération de contenu à l'étape 4. Elles peuvent supprimer, supprimer du contenu, interdire des conditions; En bref, ils peuvent désactiver les campagnes de manipulation des médias s'ils prennent les bonnes actions au bon moment. Déplacer les manipulateurs et les haineux fonctionne. Mais ces efforts d'atténuation arrivent souvent trop tard, comme la démolition des suprémacistes blancs qui ont planifié l'événement meurtrier Unite the Right ou la longue et lente croissance du mouvement QAnon. Un exemple de cela dans notre livre de cas est le cas du harcèlement ciblé d'un dénonciateur présumé, lorsque certaines entreprises de médias sociaux ont suivi l'exemple du journalisme conventionnel et ont bloqué l'utilisation d'un nom spécifique sur leurs plateformes pour protéger une personne de tout blesser.

Mais les entreprises de plateformes répondent souvent trop tard ou ne répondent pas du tout. Nous savons que des plateformes comme Facebook ont sciemment permis à la radicalisation de se propager avec des résultats mortels. Bien qu'ils aient des départements politiques axés sur la minimisation des dommages et se soient engagés à maintes reprises à faire de leurs plates-formes un environnement sûr et équitable, ils n'agissent souvent pas tant qu'ils n'ont pas été contraints de le faire par la société civile et les journalistes. Leurs efforts d'atténuation disparates ne sont ni coordonnés ni normalisés, ce qui permet aux manipulateurs de profiter d'un environnement médiatique asymétrique pour exécuter des attaques.

Dans le vide réglementaire, nous voyons à plusieurs reprises les plateformes échouer dans leur quête de protection de la marque, n'agissant que lorsqu'une campagne est terminée ou adaptée. En janvier 2020, Facebook a publié une déclaration: «En l'absence de réglementation, Facebook et d'autres entreprises doivent concevoir leurs propres politiques. Nous avons fondé le nôtre sur le principe que les gens devraient être capables d'écouter ceux qui veulent les conduire, les verrues et tout. "

Cela révèle qu'à l'étape 4, le courtier en énergie manquant est les régulateurs, qui pourraient créer des règles normalisées pour les plates-formes, mais qui ont largement renoncé à ce devoir ou l'ont trouvé trop difficile jusqu'à présent.

Étape 5: Adapter la campagne

Comme le révèlent de nombreux cas du recueil de cas, malgré certaines mesures d'atténuation, les campagnes de manipulation des médias trouvent souvent des moyens de se poursuivre. À l'étape 5, les campagnes sont adaptées lorsque cela est possible, parfois du jour au lendemain ou sur plusieurs années, comme l'étude de cas de la campagne numérique Operation Blaxit ou la théorie persistante du complot. Pizzagate. Les opérateurs connaissent souvent les meilleurs moyens d'exploiter les systèmes sociotechniques et utilisent souvent l'anonymat pour éviter l'attribution et utilisent des matériaux édités et un langage codé pour éviter le balisage automatique du contenu. Bien que ces individus ou groupes puissent être hors de question, les principales plates-formes de médias sociaux restent le principal vecteur d'attaque de telles campagnes et ont la responsabilité de limiter l'impact de ce comportement.

Une atténuation réussie de la plateforme est le seul moyen de limiter l'impact de l'adaptation par les manipulateurs. Le film "Plandemic", qui affirmait que le virus Covid-19 avait été déployé par de puissantes élites pour créer un nouvel ordre mondial, est devenu super viral au printemps 2020. Il a été retiré après avoir reçu près de deux millions de vues. Il circulait toujours sur des plates-formes vidéo plus petites. Avant l'atténuation, cette campagne de désinformation fonctionnait publiquement, notamment en annonçant précédemment un film de suivi, «Endoctrinement». Lorsque ce film est sorti, les plates-formes étaient prêtes. En prenant des mesures proactives, les grandes plateformes ont beaucoup fait pour arrêter la diffusion du documentaire et ont pu empêcher une répétition de la viralité «plandémique». Du fait de la coordination intersectorielle, «l'endoctrinement» a reçu beaucoup moins d'attention. Les manipulateurs motivés continueront de s'adapter, mais sans les capacités d'amplification des médias sociaux à leur disposition, leur public diminuera considérablement.

Il est difficile de suivre cet écosystème. Les campagnes sont difficiles à trouver, difficiles à identifier lors de leur implantation, un défi pour les journalistes, nos institutions et la société civile. Les pratiques d'atténuation inégales et non motivées des plates-formes permettent l'adaptation des gestionnaires. Mais dans le projet Technology and Social Change, nous présentons ce modèle, ouvert à de nombreuses disciplines et pratiques de recherche, comme un moyen de détecter, documenter et discréditer la désinformation sous toutes ses formes. Il s'agit d'un cadre pour les décideurs politiques qui cherchent à comprendre l'impact de la manipulation des médias hors plateforme et comment ces plateformes sont conçues pour une exploitation continue. Et nous espérons qu'il s'agit d'un modèle pour les journalistes et les chercheurs à la recherche de normes sur la manière de faire face à la crise actuelle de l'information.